微软正计划将其基于Chromium的Edge浏览器打造成Windows 11上的AI优先工具。这一努力并非空穴来风——早在2024年就有报道称,微软可能利用Phi-3模型支持Edge的部分AI功能。然而,与其依赖云端计算,微软似乎更倾向于借助本地硬件能力来实现这些功能。

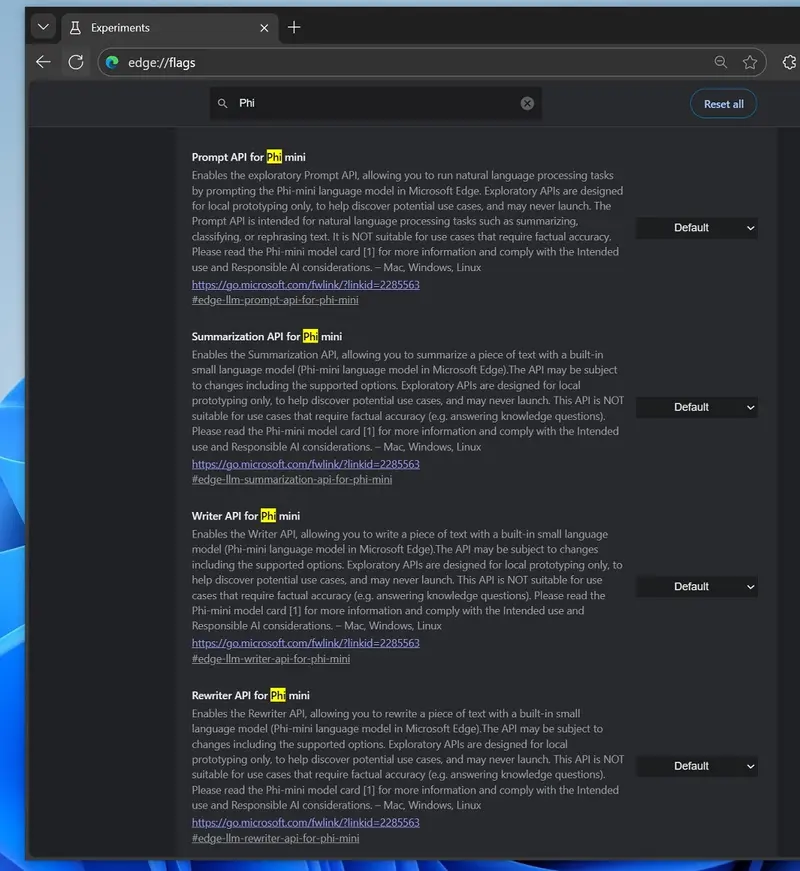

如今,最新的Edge Canary版本中出现了一些与“Phi mini”相关的实验性标志,这进一步证实了微软正在探索将小型语言模型(如Phi-4 mini)集成到浏览器中的可能性。

Phi-4 mini:高效的小型语言模型

Phi-4 mini是一种小型语言模型,与ChatGPT等大型语言模型相比,它对计算资源的需求更低,运行效率更高,同时仍能胜任复杂的推理任务。根据微软的描述,Phi-4拥有140亿个参数,在文本生成、分类和改写等任务中表现出色。

与依赖云端的大型模型不同,Phi-4 mini更适合在本地设备上运行。这意味着,微软可以通过将其集成到Edge浏览器中,为用户提供快速、低延迟的AI体验,而无需依赖网络连接或高昂的云端计算成本。

Edge中的Phi-4 mini API:本地化AI任务的新尝试

在Edge Canary 138.0.3323.0或更新版本中,已经出现了多个与Phi-4 mini相关的API标志。这些API允许用户通过Edge浏览器本地运行一些常见的AI任务,例如:

- 总结文本:使用Phi-4 mini快速提炼长篇文章的核心内容。

- 撰写文本:生成符合需求的段落或短文。

- 改写文本:对现有内容进行润色或重新表述。

不过,微软明确表示,这些API目前仍处于实验阶段,并不适用于事实核查等需要高准确性的任务。

值得注意的是,Edge浏览器目前已有一个名为“与Copilot一起改写”的功能,但它依赖于云端计算。相比之下,Phi-4 mini的本地化处理方式更具隐私性和即时性,尤其是在没有稳定网络连接的情况下。

硬件要求:NPU还是GPU?

尽管Phi-4 mini对计算资源的需求较低,但其具体运行环境仍是一个未知数。微软是否会要求设备配备专用的神经处理单元(NPU),还是允许任何具备一定性能的GPU(显卡)完成任务?目前尚无定论。

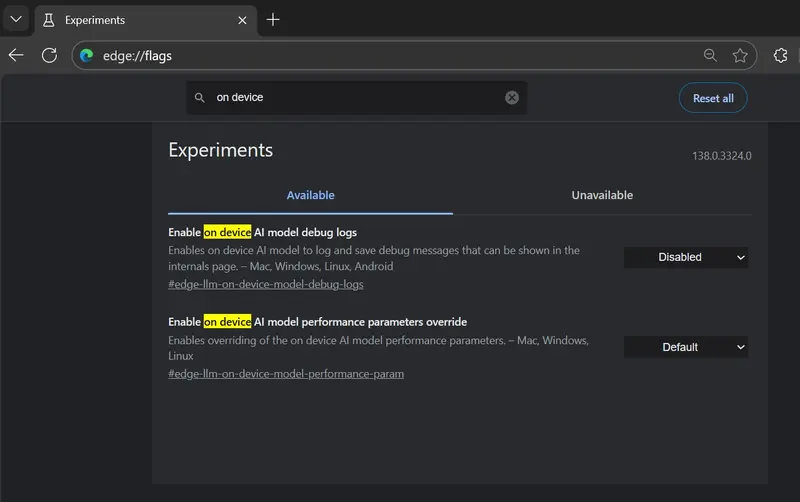

此外,Edge Canary中还出现了两个额外的标志,进一步表明微软正在测试“设备本地”的AI功能:

- 启用设备本地AI模型性能参数覆盖:允许绕过所有性能限制,可能用于调试和优化。

- 本地AI日志调试:帮助开发者记录和分析本地AI运行时的表现。

这些标志的存在进一步验证了微软正在积极探索如何让Edge浏览器更好地利用本地硬件资源来处理AI任务。

展望未来:实验阶段的潜在影响

尽管这些功能听起来令人兴奋,但需要注意的是,它们仍处于实验阶段,最终是否会被正式推出仍是未知数。微软可能会根据测试结果决定是否继续优化Phi-4 mini或其他类似模型。

如果成功,这项技术将为Edge浏览器带来显著优势,尤其是在隐私保护和离线使用场景中。对于那些希望减少对云端依赖的用户来说,这种“设备本地”的AI功能无疑是一大进步。

评论