OpenAI 近日发布了其首个开放权重(open-weight)模型 gpt-oss,引发广泛关注。

这款模型不仅声称在推理能力上可媲美自家的 o4-mini,更关键的是:它可以在本地设备上运行。这意味着,即使没有 API 访问权限或无法使用 VPN,用户也能在自己的电脑上部署并使用接近 ChatGPT 水准的 AI 模型。

然而,一个现实问题摆在面前:你的电脑,真的跑得动吗?

本地运行 AI 模型,硬件是关键

虽然 gpt-oss 的具体参数尚未完全公开,但根据社区推测,它可能属于 7B-13B 级别的模型。这类模型对硬件有一定要求:

- 内存(RAM)不足:模型无法加载

- CPU 性能弱:生成速度极慢,体验卡顿

- 无 GPU 支持:推理效率大幅下降

盲目下载后发现“根本带不动”,只会浪费时间和存储空间。

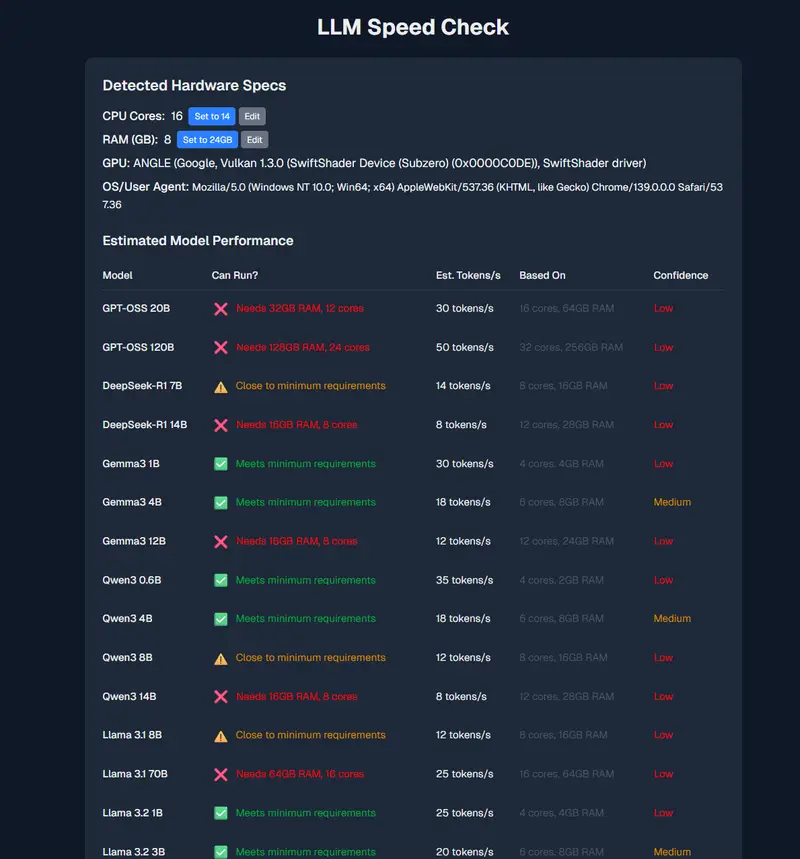

为此,我们推荐一个实用工具:LLM Speed Check。

LLM Speed Check:一键评估你的电脑能否运行 AI 模型

LLM Speed Check 是一个免费在线工具,专为想在本地部署 AI 模型的用户设计。

它能帮助你快速判断:

- 哪些开源模型可以在你的设备上运行

- 预期的生成速度(每秒 token 数)

- 是否值得投入时间进行部署

主要功能包括:

✅ 自动硬件检测

访问网站后,它会自动识别你的:

- CPU 核心数

- 内存(RAM)容量

- GPU 型号(若支持 WebGPU)

✅ 多模型支持对比

目前已涵盖主流轻量级开源模型,例如:

- gpt-oss(OpenAI)

- DeepSeek-R1 7B(深度求索)

- Gemma3 1B / 7B(Google)

- Phi-3(Microsoft)

- Llama 3 系列(Meta)

✅ 性能预估

基于你的硬件配置,网站会从其基准测试数据库中匹配相似设备,并估算每个模型的 tokens per second (TPS),让你直观了解运行流畅度。

✅ 支持手动输入配置

如果你使用的是远程服务器或虚拟机,无法自动检测,也可以手动输入 CPU、内存等信息,获得更精准的评估。

评论