想在手机上使用AI聊天,又担心个人数据上传到第三方服务器?PocketPal AI 提供了一种解决方案——这款免费开源应用能让你在Android或iPhone上本地运行小型语言模型(SLM),所有对话和数据都储存在设备内,无需联网即可使用。无论是日常隐私查询、特定任务处理,还是轻度内容生成,它都能以低门槛操作满足需求。本文将从功能解析、使用教程、实际体验到局限性,帮你全面了解这款工具。

PocketPal AI 是什么?核心优势在哪?

在使用前,先理清PocketPal AI的定位与核心价值,判断它是否符合你的需求:

1.手机端的“离线隐私AI工具”

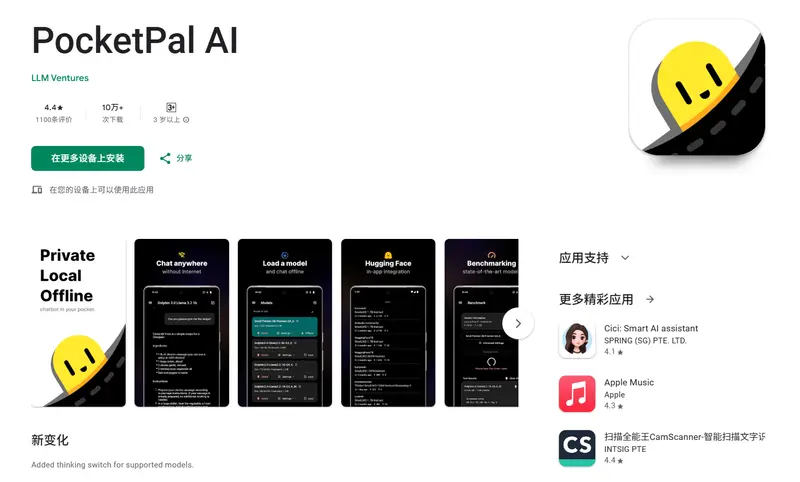

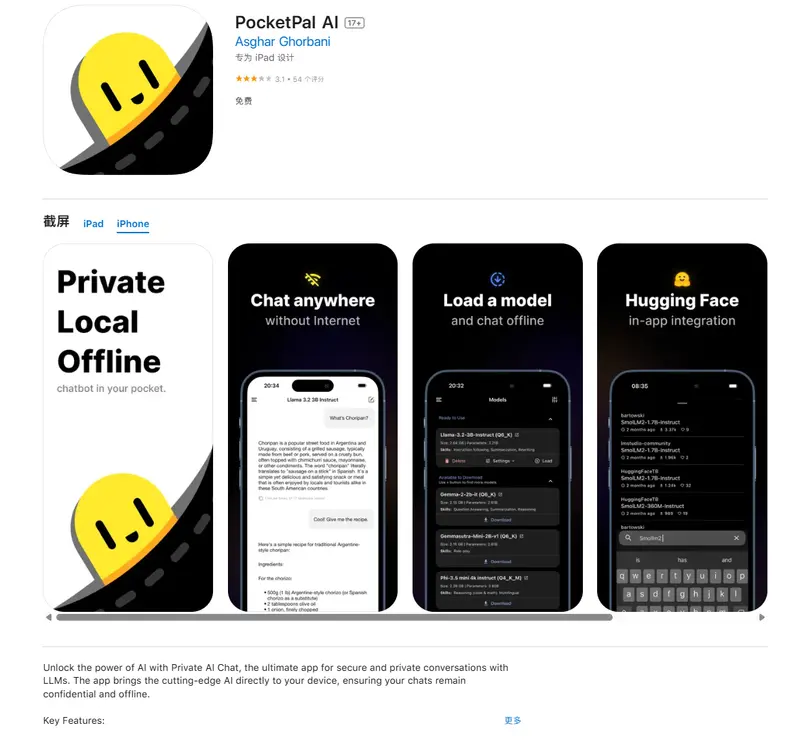

PocketPal AI 是一款完全免费的开源应用,核心功能是在智能手机本地部署并运行小型语言模型(SLM) ——不同于ChatGPT、Gemini等依赖云端服务器的AI,它的所有计算都在你的手机内完成,查询内容、对话记录不会上传到任何外部服务器,从根源上保障隐私。

它支持Android和iOS双平台,适配大多数现代智能手机,且无需复杂的环境配置,小白也能快速上手。

2. 核心能力:模型选择、个性化设置全覆盖

- 丰富的模型库:内置Phi、Gemma、Qwen等主流开源模型,还支持从Hugging Face(AI模型社区)导入更多模型——哪怕是Hugging Face上的受限模型,只需在设置中填入个人认证令牌,就能直接下载使用;

- 自定义推理参数:可调整系统提示、温度(控制回答随机性)、序列开始(BOS)令牌、聊天模板等参数,比如将“温度”调低让回答更严谨,或通过系统提示定义AI的回复风格;

- “伙伴”(Pals)功能:支持创建个性化AI角色,分为两类:

- 助手伙伴:适配特定任务场景,比如“学习伙伴”可针对研究项目提供上下文感知的回答,“行政伙伴”能辅助起草邮件、总结报告;

- 角色扮演伙伴:用于模拟对话场景,比如模拟客户沟通、语言学习对话等;

- 多模态支持:部分模型(如SmolVLM2-500M-Instruct)可分析图像,通过相机拍摄或导入图库图片,AI能生成图像内容描述、提取关键信息。

对比同类工具:PocketPal AI 为什么更易上手?

手机端本地运行AI的工具并非只有PocketPal AI,但它的几个特点让其在“易用性”上脱颖而出:

| 对比维度 | PocketPal AI | 其他同类应用(如LMSA) |

|---|---|---|

| 费用模式 | 完全免费,无功能限制 | 多为“免费基础版+付费高级版”,部分核心功能需付费 |

| 模型获取难度 | 内置模型直接下载,支持Hugging Face一键导入 | 需手动复制模型链接,部分不支持第三方模型导入 |

| 操作复杂度 | 界面简洁,参数设置可视化,无需代码基础 | 部分需手动修改配置文件,对新手不友好 |

| 社区支持 | 支持手机端运行基准测试,可分享测试结果 | 缺乏社区互动功能,无法参考其他用户的设备适配经验 |

简单来说,其他工具要么有付费门槛,要么操作复杂,而PocketPal AI用“零成本+可视化操作”降低了手机本地AI的使用门槛。

实操教程:3步搞定PocketPal AI 安装与使用

整个设置过程不超过10分钟,只需按以下步骤操作:

1. 下载与权限授予

- Android用户:从Google Play商店或GitHub(需确认官方链接,避免第三方渠道)下载安装包;

- iPhone用户:在App Store搜索“PocketPal AI”下载;

- 安装完成后启动应用,授予“存储权限”(用于保存模型和对话记录)、“相机/相册权限”(如需使用图像分析功能),无需其他多余权限。

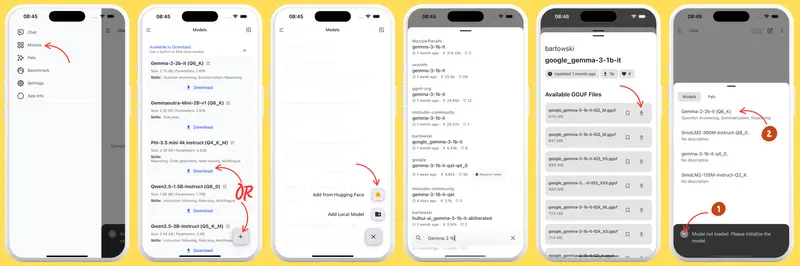

2. 下载并加载适合的模型

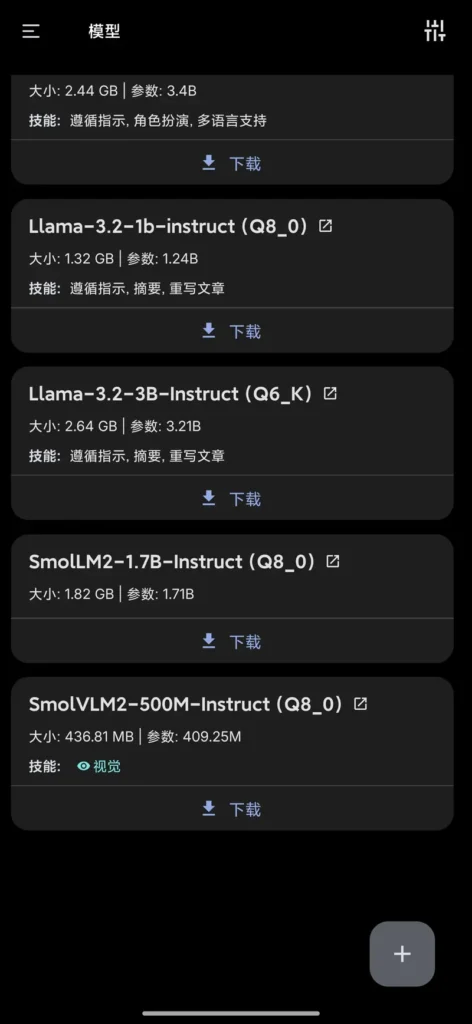

模型体积通常在几百MB到几GB不等,建议连接稳定Wi-Fi下载,避免消耗手机流量:

- 进入应用主界面,点击“下载模型”按钮;

- 在“可下载”列表中,每个模型都会标注大小、参数规模(如2B、3B,数字越小对硬件压力越小)、擅长技能(如“文本总结”“多模态分析”),根据手机配置选择:

- 中端手机(8GB内存):优先选2B-3B参数模型(如Gemma-2-2b-it、Phi-3.5 mini),运行更流畅;

- 高端手机(12GB+内存):可尝试7B参数模型(如Llama-3.2-7B-Instruct),功能更全面;

- 点击模型名称查看详情,确认后点击“下载”,等待下载完成;

- 下载结束后,点击模型卡上的“加载”按钮,模型会进入手机内存,此时界面会切换到聊天窗口,即可开始交互。

3. 开始使用:基础交互与功能拓展

- 基础聊天:在文本框输入问题(如“总结一段文字”“解释量子力学基础概念”),模型会实时生成回答,可点击“新对话”开启新话题;

- 启用“伙伴”:点击文本框左侧的向上箭头,切换到“伙伴” tab,选择已有的伙伴(如Gemma的Lookie伙伴可分析视频),或点击“创建”自定义新伙伴;

- 导出/导入对话:点击右上角三点菜单,选择“导出/导入”,可导出所有会话(保存为文件),或导入之前的会话继续对话;

- 图像分析:对支持多模态的模型(如SmolVLM2-500M-Instruct),点击文本框左侧“+”,选择“相机”拍摄或“图库”导入图片,AI会自动分析并生成描述。

实际体验:哪些手机能用?性能表现如何?

1. 设备适配:8GB内存是关键门槛

PocketPal AI对硬件有一定要求,实测结果显示:

- 推荐配置:8GB内存及以上的现代智能手机(如红米K80、iPhone 15系列),运行2B-3B参数模型时响应迅速,无明显卡顿;

- 最低配置:6GB内存手机,可运行1B参数以下的轻量模型(如Phi-2-1.3B),但处理复杂查询时可能出现响应延迟;

- 不推荐配置:4GB及以下内存手机,容易出现模型加载失败或应用崩溃。

2. 性能表现:响应速度与模型选择强相关

在红米K80(16GB内存)上测试不同模型,表现如下:

- Gemma-2-2b-it(2B参数):回答日常问题(如“推荐3本编程入门书”)耗时约2-3秒,无卡顿;

- SmolVLM2-500M-Instruct(500M参数):分析一张风景图并生成描述,耗时约4-5秒,图像识别准确率较高;

- Llama-3.2-3B-Instruct(3B参数):撰写300字的产品介绍文案,耗时约5-6秒,内容逻辑清晰。

偶尔会出现“处理中途停止响应”的情况,多因模型参数设置不当(如序列长度过长),调整参数后可解决,并非应用本身的稳定性问题。

3. 模型选择建议:根据需求匹配能力

不同模型的擅长领域差异较大,选择时需结合使用场景:

- 日常问答、简单总结:选Phi-3.5 mini(参数小、速度快);

- 多模态分析(图文结合):选SmolVLM2-500M-Instruct;

- 复杂任务(如代码生成、深度对话):选Gemma-2-2b-it或Llama-3.2-3B-Instruct(参数更大,理解能力更强)。

局限性:这些场景不适合用PocketPal AI

尽管PocketPal AI在隐私和易用性上有优势,但受限于“本地小型模型”的属性,它无法替代云端大模型(LLM),主要局限性包括:

- 无法获取实时信息:由于离线运行,无法查询最新新闻、股市行情、实时天气等动态数据;

- 功能覆盖范围窄:小型模型参数有限,不支持复杂任务(如深度数据分析、专业领域问答、高质量创意写作),比如无法生成细腻的小说片段,或解答复杂的法律问题;

- 语言理解精度不足:对模糊查询、多歧义问题的处理能力较弱,比如无法精准理解“推荐适合学生党且性价比高的无线耳机”这类带多个限定条件的需求。

因此,建议采用“互补使用”策略:隐私性需求(如查询个人健康数据、起草私密文档)用PocketPal AI;复杂或实时需求(如分析最新行业报告、生成创意视频脚本)用ChatGPT、Gemini等云端大模型。

评论