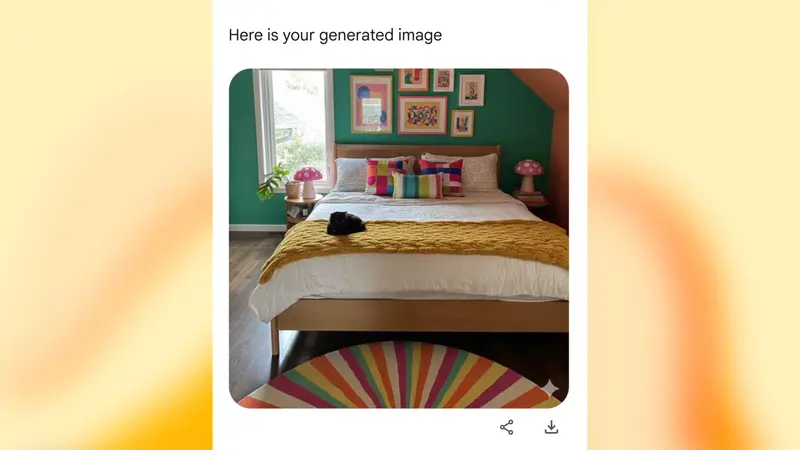

Google 最近为其搜索应用引入了一项新功能:在 Google Lens 中集成名为 Nano Banana 的 AI 图像模型,允许用户直接对图片进行 AI 驱动的编辑。Android 和 iOS 用户将在 Lens 界面中看到一个“创建”模式——你可以拍摄新照片,或从相册选择已有图像,然后即时修改、重绘或转换其内容。

这意味着,Google 搜索不再只是“用图搜图”,还能把图像当作创意画布,在应用内完成编辑。

但问题是:这个功能放在搜索里,合理吗?

Google Lens 的核心定位一直是视觉搜索工具——识别物体、翻译文字、查找商品。现在突然加入生成式图像编辑,就像在五金店中间摆了个冰淇淋摊:东西本身不差,也有人会用,但场景错位,显得突兀。

相比之下,Nano Banana 在其他产品中的集成更有逻辑。

在 NotebookLM 中,该模型用于增强其新推出的 Video Overviews 功能。它能基于用户提供的资料(如文档或视频)自动生成带插图的摘要,并提供六种视觉风格选项,包括水彩、动漫等。此外,NotebookLM 还新增了“Brief”格式,用于输出简明扼要的视觉化洞察。这些改进确实有助于提升信息理解和笔记效率。

而即将登陆 Google 照片 的 Nano Banana 集成,则显得顺理成章。Google 照片本就具备基础的照片编辑能力(如裁剪、调色、修复),引入 AI 编辑作为进阶功能,符合用户对照片管理应用的预期。

目前,上述功能已陆续上线或即将推出。对于普通用户而言,是否使用这些新能力,取决于实际需求;但对于 Google 来说,如何在“功能丰富”和“体验聚焦”之间取得平衡,或许比堆砌 AI 更重要。

评论