最近,一个看似细微的技术调整,却在 AI 行业引发广泛讨论:

微软正在其旗舰开发工具 Visual Studio Code 中,优先使用 Anthropic 的 Claude Sonnet 4,而非自家重金投资的 OpenAI 所推出的 GPT-5。

这一变化并非简单的产品功能更新,而是透露出微软 AI 战略的一次关键转向——

性能优先,而非立场绑定。

新功能:GitHub Copilot 将自动选择最佳模型

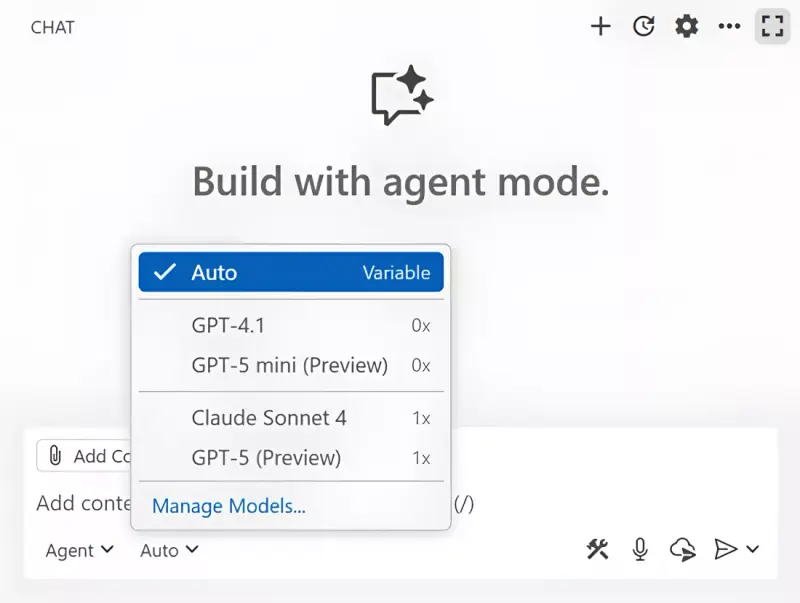

微软正在为 GitHub Copilot 推出一项新功能:自动 AI 模型选择(Auto Model Selection)。

该功能会根据任务类型、上下文复杂度和模型表现,动态决定调用哪个大模型来提供代码建议。

具体策略如下:

| 用户类型 | 主要使用的模型 |

|---|---|

| 付费用户 | Claude Sonnet 4(为主) |

| 免费用户 | 混合使用 GPT-5、GPT-5 mini 及其他候选模型 |

这意味着,在实际编码场景中,许多开发者将更多地接触到 Anthropic 的模型,而不是 OpenAI 的最新成果。

内部导向早已明确

据《The Verge》援引熟悉微软开发者计划的消息人士称,微软已数月前就指导工程师优先采用 Claude Sonnet 4 进行内部测试与集成。

2024年6月,微软开发者部门负责人 Julia Liuson 明确表示:

“根据我们的内部基准测试,Claude Sonnet 4 是目前 GitHub Copilot 的推荐模型。”

值得注意的是,这番表态发生在 GPT-5 正式发布(8月)之前。而即便在 GPT-5 上线后,微软也未改变其技术选型方向。

为什么是 Claude Sonnet 4?

虽然微软未公开详细评测数据,但从开发者反馈和典型编码任务的表现来看,Claude Sonnet 4 在以下几个方面展现出优势:

- 长上下文理解更稳定:支持高达 200K token,适合处理大型项目文件;

- 代码结构推理能力更强:在函数补全、错误修复、注释生成等任务中准确率更高;

- 响应延迟更低:尤其在中等复杂度请求下,首字节时间优于同类模型;

- 对多语言项目兼容性好:在混合技术栈环境中表现更一致。

这些特性恰好契合 IDE 场景的需求——高精度、低延迟、强上下文保持能力。

背后的战略信号:微软不再“唯一押注”

自2019年以来,微软已向 OpenAI 投资超过 130亿美元,并深度整合其模型至 Azure、Office、Windows 等全线产品。两者关系一度被视为“最紧密的科技联盟”。

然而,近期动作表明,这种合作正变得更加务实:

- 引入 Anthropic 模型进入核心产品链

- 不仅限于 VS Code,部分 Microsoft 365 应用(如 Excel 和 PowerPoint)也在内测中评估 Anthropic 模型在文档生成、数据分析等场景的表现。

- 推动多模型共存机制

- 自动模型选择机制意味着未来 Copilot 不再依赖单一供应商,而是形成“模型池”,按需调度最优资源。

- 加强自研能力建设

- 微软 AI 负责人 Mustafa Suleyman 最近透露,公司正大力投入自研 AI 基础设施。

- 其预览模型 MAI-1-preview 使用约 15,000 颗 H100 GPU 训练,在行业标准下虽非最大规模,但标志着自研路径的实质性进展。

- 开放 OpenAI 商业路径

- 上周,微软与 OpenAI 达成新协议,允许后者使用除 Azure 外的云平台进行训练,为可能的 IPO 铺路。

- 这一松绑也反映出双方关系正从“深度绑定”向“有限协同”演变。

对开发者意味着什么?

对于每天使用 VS Code 和 Copilot 的程序员来说,这次变化的实际影响是积极的:

- ✅ 更高质量的代码建议

- ✅ 更少的误补全和逻辑错误

- ✅ 更自然的注释与文档生成

- ✅ 更流畅的长文件上下文体验

更重要的是,它传递了一个信号:

你所使用的 AI 工具,将越来越基于“好不好用”,而不是“是谁家的孩子”。

评论