想在自己的电脑上运行 AI 模型,既不用依赖网络,也不用担心数据被上传到第三方服务器?Ollama 正是这样一款工具——它能让你在本地轻松部署大语言模型(LLM),无论是日常聊天、代码生成,还是项目头脑风暴,都能离线完成。本文将从基础概念到实操步骤,带你完整掌握 Ollama 的安装、模型使用与卸载,适合零基础用户入门。

一、先搞懂:Ollama 是什么?为什么选它做本地 AI?

在开始操作前,先明确 Ollama 的核心价值,帮你判断它是否符合需求:

Ollama 是一款轻量级本地 AI 管理工具,核心功能是“简化大语言模型的部署流程”——你不需要懂复杂的代码编译或环境配置,通过简单的指令就能下载、运行 AI 模型。它的核心优势有三点:

- 全离线运行:所有模型和数据都存储在本地电脑,无需联网,避免隐私数据外泄;

- 多模型支持:兼容从 10 亿参数(1B)的轻量模型到数百亿参数的大型模型,适配不同硬件;

- 低门槛操作:无需专业技术,通过终端/命令行即可完成模型管理,对新手友好。

当然,它也有局限性:部分大模型体积庞大(可能超过 10GB),且对电脑硬件(尤其是显卡、内存)有一定要求。不过对于日常基础任务(如简单问答、文本总结),轻量模型完全能满足需求,且对硬件压力较小。

二、实操:Ollama 安装步骤(Windows/macOS/Linux 通用)

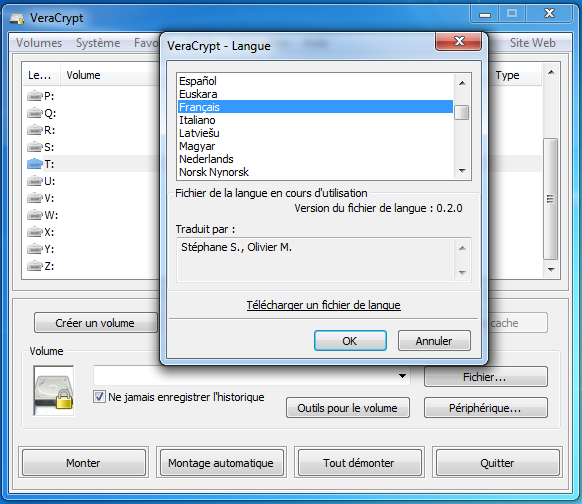

Ollama 的安装流程非常简洁,全平台操作逻辑一致,以 Windows 11 为例,3 步即可完成:

- 下载安装包

打开 Ollama 官方网站(ollama.com),首页会自动识别你的操作系统(Windows/macOS/Linux),点击对应版本的“Download”按钮,等待安装包下载完成。 - 执行安装

双击下载的安装包,按照弹窗提示点击“下一步”即可——无需手动选择安装路径,程序会自动完成配置,全程无需复杂设置,小白也能轻松操作。 - 验证安装成功

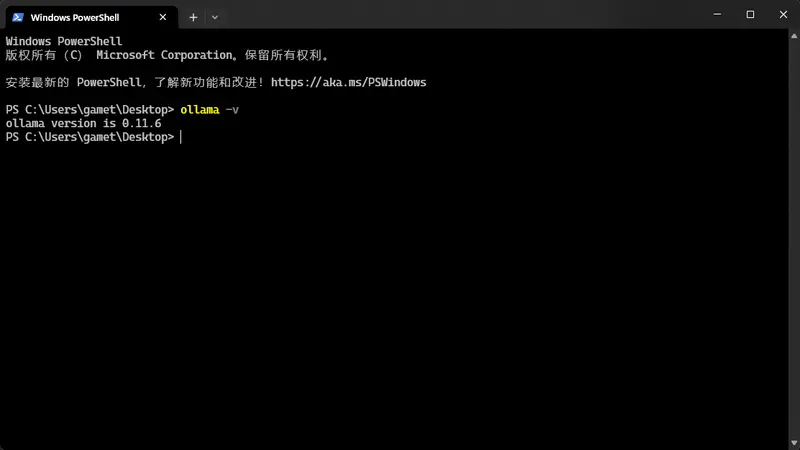

安装完成后,Windows 用户打开「PowerShell」(按下 Win+R,输入powershell回车),macOS/Linux 用户打开「终端」,输入指令ollama -v。如果终端显示 Ollama 的版本号(如ollama version 0.1.48),说明安装成功;若提示“命令不存在”,可重启电脑后再次尝试。

三、关键步骤:选择并下载适合你硬件的 AI 模型

安装完成后,核心是选对模型——不同模型的参数规模对应不同的硬件需求,选错模型可能导致运行卡顿甚至无法启动。

1. 先看模型参数与硬件匹配表

首先根据你的电脑配置,选择对应的模型规模:

| 模型规模 | 参数范围 | 适配硬件 | 适合场景 | 代表模型 |

|---|---|---|---|---|

| 小型模型 | 1B–8B(10亿-80亿) | 普通笔记本(32GB 内存+独立显卡) | 简单问答、文本总结、基础聊天 | qwen3和gemma3系列小参数模型 |

| 中型模型 | 13B–32B(130亿-320亿) | 高端 PC(64GB 内存+高端显卡) | 代码生成、深度对话、创意写作 | qwen3和gemma3系列大参数模型 |

| 超大型模型 | 100B+(百亿以上) | 专业工作站 | 复杂任务、专业领域问答 | gpt-oss系列模型、deepseek-r1 |

2. 下载模型的具体操作

通过终端/PowerShell 指令即可下载模型,步骤如下:

- 打开终端(Windows 用 PowerShell,macOS/Linux 用终端);

- 输入模型下载指令,格式为

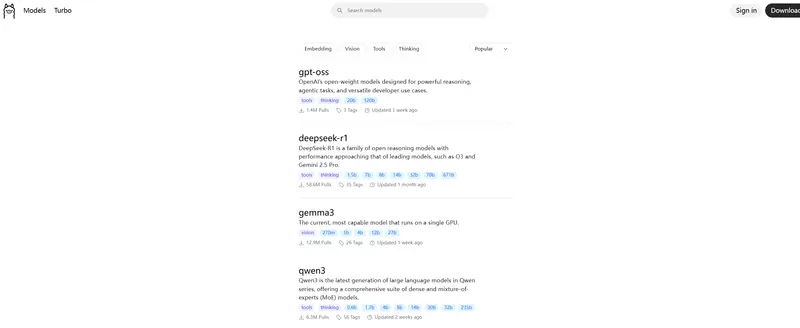

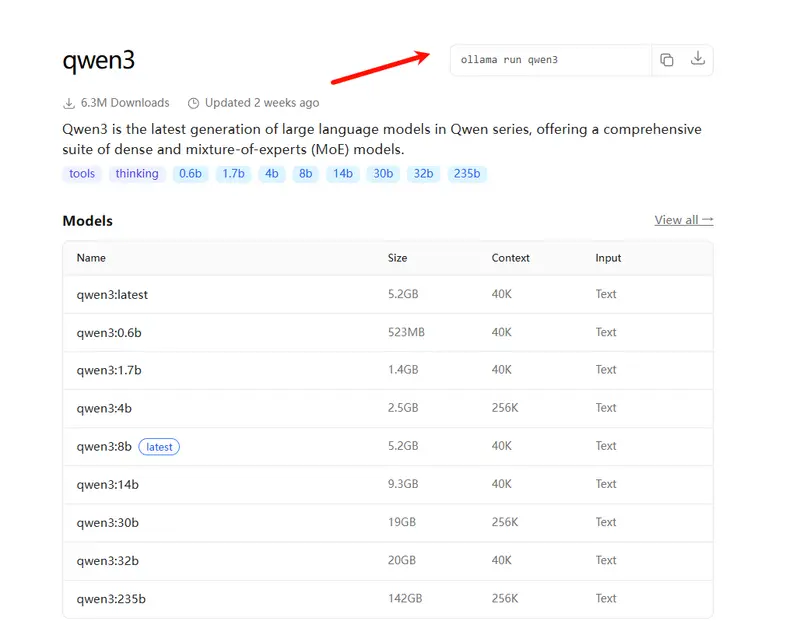

ollama run 模型名称(模型名称可在 Ollama 官网「Models」页面查询);

示例:若想下载适合普通笔记本的“gemma3:1b”模型,输入ollama run gemma3:1b;

若想下载适合高端 PC 的“qwen3:32b”模型,输入ollama run qwen3:32b; - 按下回车后,程序会自动开始下载模型(模型体积较大,32B 模型约 20GB,建议在 Wi-Fi 环境下下载);

- 下载完成后,终端会提示“success”,表示模型已就绪。

四、开始使用:用指令启动模型,完成日常任务

模型下载后,通过简单指令即可启动并互动,无需打开额外软件。

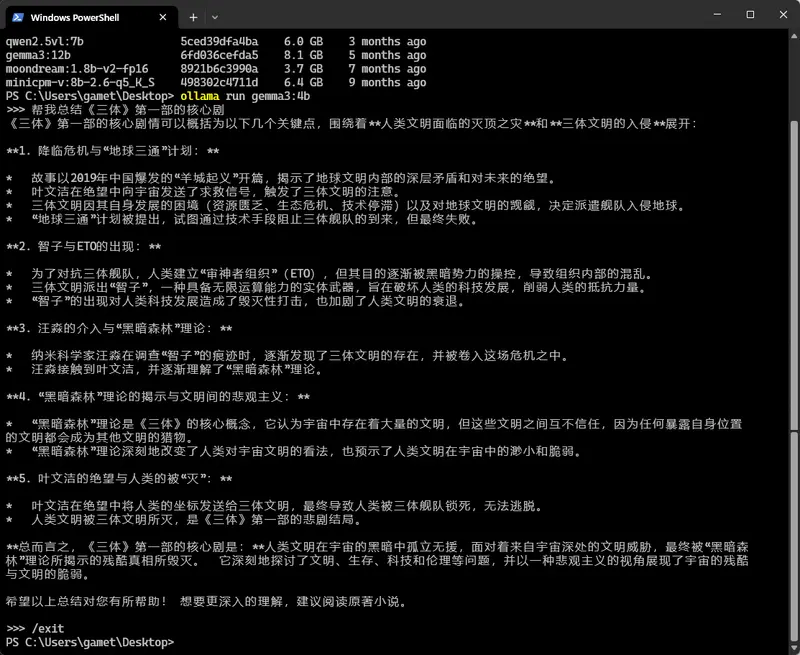

1. 启动模型并聊天

- 在终端输入

ollama run 模型名称,示例:ollama run qwen3:32b; - 等待 1-2 秒(首次启动需加载模型,时间稍长),终端会显示“>”符号,此时可输入你的需求,比如:

- 聊天需求:

帮我总结《三体》第一部的核心剧情; - 代码需求:

用 Python 写一个批量处理 Excel 表格的脚本; - 创意需求:

为我的咖啡小店写一段开业宣传文案;

- 聊天需求:

- 模型会在终端实时输出回答,若想结束对话,输入

/exit即可退出模型。

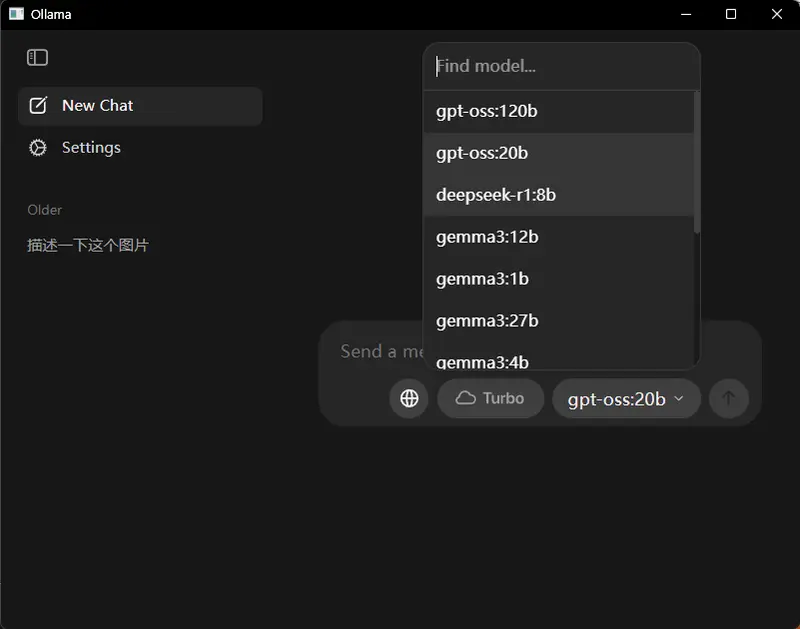

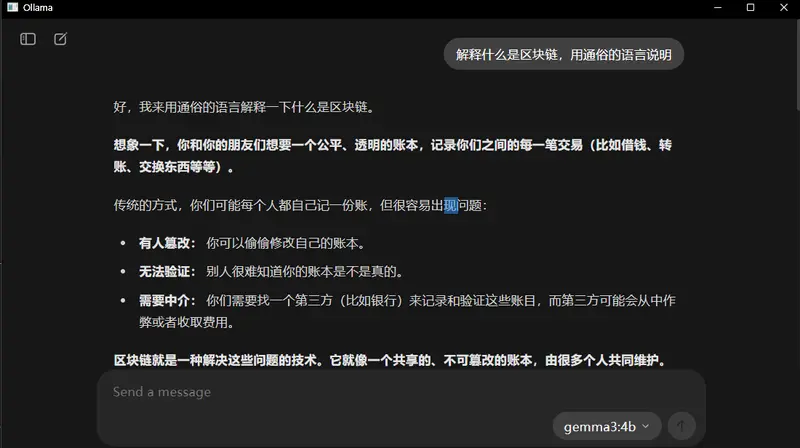

2.使用GUI界面

Ollama从v0.10.0 版本首次引入了图形用户界面(GUI),不再局限于命令行操作,现在非技术用户也能轻松上手。

3. 常见任务的指令示例

不同任务无需切换模型(只要模型支持该功能),直接用自然语言描述需求即可,以下是常见场景的使用示例:

| 任务类型 | 输入指令示例 | 模型响应效果 |

|---|---|---|

| 文本总结 | 总结下面这段文字:[粘贴需要总结的内容] | 提取核心观点,生成 300 字以内摘要 |

| 代码辅助 | 帮我调试这段 JavaScript 代码,报错是... | 指出错误原因,提供修改方案 |

| 问题解答 | 解释什么是区块链,用通俗的语言说明 | 避免专业术语,用类比方式讲解 |

| 头脑风暴 | 为我的旅行 vlog 想 5 个创意主题 | 列出具体主题,附带内容方向 |

五、进阶技巧:优化性能与扩展功能

如果想让 Ollama 用得更顺手,可以试试这些实用技巧:

1. 提升模型运行速度

- 若电脑有英伟达显卡,可安装 CUDA 工具包(Ollama 会自动调用 GPU 加速,需确保显卡驱动是最新版本);

- 避免同时运行多个模型或大型软件(如视频剪辑工具),减少内存占用;

- 若运行卡顿,可切换到更小参数的模型(比如从 13B 换成 8B)。

2. 集成到程序(适合开发者)

如果想将 Ollama 模型嵌入到自己的项目中(如搭建本地聊天机器人),可通过 API 或 Python 库实现:

- 用 Python 调用:搭配 LlamaIndex 或 LangChain 库,实现“模型+本地文档问答”(比如让 AI 基于你的本地笔记回答问题);

- 调用 API:Ollama 支持本地 API 接口,在终端输入

ollama serve启动服务后,即可通过代码调用模型(具体文档见 Ollama 官网「API」页面)。

六、收尾:卸载模型或 Ollama 的完整步骤

如果不再需要某个模型或想彻底删除 Ollama,按以下步骤操作,避免残留文件占用空间:

1. 卸载单个模型(释放存储空间)

- 打开终端,输入

ollama list查看已安装的模型(终端会显示模型名称和大小); - 输入

ollama rm 模型名称卸载指定模型,示例:ollama rm llama3:8b; - 终端提示“success”,表示模型已删除,可释放对应存储空间(如 8B 模型约释放 4GB 空间)。

2. 彻底卸载 Ollama 及所有模型文件

- 卸载 Ollama 程序:

- Windows:打开「控制面板」→「程序和功能」,找到“Ollama”,右键选择“卸载”,按提示完成操作;

- macOS:将“应用程序”文件夹中的“Ollama”拖到废纸篓,然后清空废纸篓;

- Linux:在终端输入

sudo apt remove ollama(Debian/Ubuntu 系统)或对应卸载指令;

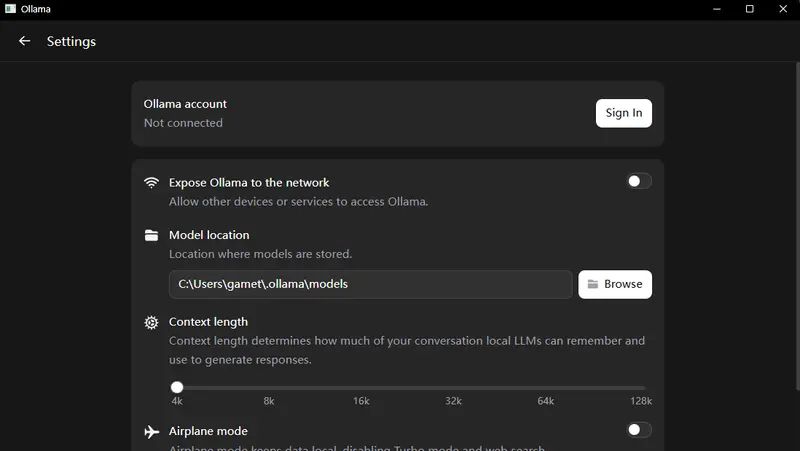

- 删除残留的模型文件(避免占用空间):

- Windows:打开路径

C:\Users\你的用户名\.ollama\models,删除该文件夹下的所有文件; - macOS:打开「访达」,按下

Shift+Command+G,输入~/.ollama/models,删除文件夹内容; - Linux:在终端输入

sudo rm -rf /usr/share/ollama/.ollama/models。

- Windows:打开路径

评论